nnetのサイズは階層を表わすと思っていたら違った。

昨日のsin関数を作るニューラルネットワークを視覚化できることがわかったので

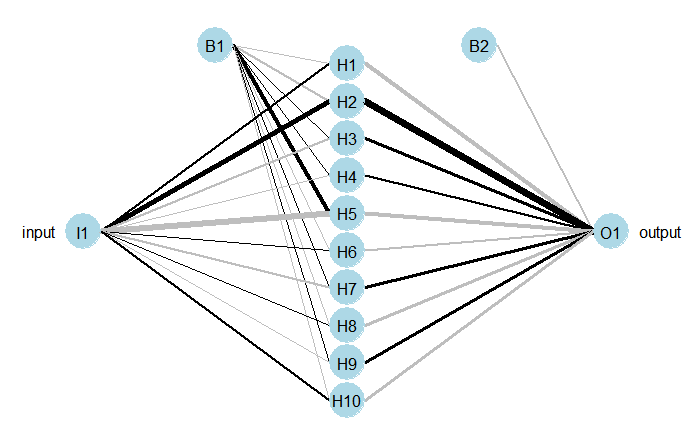

サイズ10でやってみると、

つまりサイズは中間層の数だった。

しかもとても単純なネットである。

線の太さは重みの数値の大きさ、黒は正の数で鼠色は負の数だろう。

B1とB2は重み1と決まっている入力。

次は入力層を複数にしたらどうなるのだろう。

こんな単純なNNなのに関数を表わすことがなぜできるのだろう?

これについて、普遍性定理というのがあることを知った。

ここにあらすじが書いてある。

「与えられた連続関数をどこまでも近似することができる3層のNNが必ず存在する」

という定理。

これをもっと視覚的にわかりやすく説明してあるのが次のサイト

初心者向けニューラルネットワークの基礎

これならGeoで作れそう。